Por qué RAG fracasa a escala empresarial

Las empresas han adoptado rápidamente RAG (Retrieval-Augmented Generation) para fundamentar sus LLMs en datos propietarios. Sin embargo, muchas organizaciones están descubriendo que el retrieval ya no es una característica adicional al modelo de inferencia, sino una dependencia sistémica fundamental.

Cuando los sistemas de IA se despliegan para soportar toma de decisiones, automatizar flujos de trabajo u operar de manera semi-autónoma, las fallas en el retrieval se propagan directamente al riesgo empresarial. El contexto desactualizado, las rutas de acceso sin gobernanza y las pipelines de retrieval mal evaluadas no solo degradan la calidad de las respuestas: socavan la confianza, el cumplimiento y la fiabilidad operativa.

Las primeras implementaciones de RAG fueron diseñadas para casos de uso limitados: búsqueda de documentos, Q&A interno y copilots operando en dominios estrechamente definidos. Estas soluciones asumían corpus relativamente estáticos, patrones de acceso predecibles y supervisión humana. Esos supuestos ya no se sostienen.

Los sistemas empresariales de IA modernos dependen cada vez más de:

- Fuentes de datos que cambian continuamente

- Razonamiento multi-paso a través de dominios

- Flujos de trabajo impulsados por agentes que recuperan contexto de manera autónoma

- Requisitos regulatorios y de auditoría vinculados al uso de datos

En estos entornos, las fallas de retrieval se amplifican rápidamente. Un único índice desactualizado o una política de acceso mal definida puede generar efectos en cascada en múltiples decisiones posteriores. Tratar el retrieval como una mejora ligera a la lógica de inferencia oculta su creciente rol como superficie de riesgo sistémico.

Freshness: un problema de sistemas, no de ajuste fino

Los fallos de frescura rara vez se originan en los modelos de embeddings. Se originan en el sistema que los rodea.

La mayoría de las stacks de retrieval empresariales luchan por responder preguntas operativas básicas:

- ¿Con qué rapidez se propagan los cambios de las fuentes hacia los índices?

- ¿Qué consumidores siguen consultando representaciones desactualizadas?

- ¿Qué garantías existen cuando los datos cambian durante una sesión?

En plataformas maduras, la frescura se aplica mediante mecanismos arquitectónicos explícitos en lugar de reconstrucciones periódicas. Estos incluyen reindexación impulsada por eventos, embeddings versionados y conciencia en tiempo de retrieval sobre la obsolescencia de los datos.

El patrón recurrente es que los fallos de frescura emergen cuando los sistemas fuente cambian continuamente mientras las pipelines de indexación y embedding se actualizan de manera asíncrona, dejando a los consumidores de retrieval operando sin saberlo sobre contexto obsoleto. Como el sistema sigue produciendo respuestas fluidas y plausibles, estas brechas a menudo pasan desapercibidas hasta que los flujos de trabajo autónomos dependen del retrieval continuamente y surgen problemas de fiabilidad a escala.

La gobernanza debe extenderse a la capa de retrieval

La mayoría de los modelos de gobernanza empresarial fueron diseñados para el acceso a datos y el uso del modelo de manera independiente. Los sistemas de retrieval se encuentran incómodamente entre ambos.

El retrieval sin gobernanza introduce varios riesgos:

- Modelos accediendo a datos fuera de su alcance previsto

- Campos sensibles filtrándose a través de embeddings

- Agentes recuperando información sobre la cual no están autorizados a actuar

- Incapacidad para reconstruir qué datos influyeron en una decisión

En arquitecturas centradas en retrieval, la gobernanza debe operar en fronteras semánticas en lugar de solo en capas de almacenamiento o API. Esto requiere aplicación de políticas vinculadas a consultas, embeddings y consumidores posteriores, no solo a datasets.

La gobernanza efectiva de retrieval típicamente incluye:

- Índices con alcance de dominio y propiedad explícita

- APIs de retrieval conscientes de políticas

- Pistas de auditoría que vinculan consultas con artefactos recuperados

- Controles sobre el retrieval cross-domain por agentes autónomos

Sin estos controles, los sistemas de retrieval evitan silenciosamente salvaguardas que las organizaciones asumen que están en su lugar.

La evaluación no puede detenerse en la calidad de la respuesta

La evaluación tradicional de RAG se centra en si las respuestas parecen correctas. Esto es insuficiente para sistemas empresariales.

Las fallas de retrieval a menudo se manifiestan antes de la respuesta final:

- Documentos irrelevantes pero plausibles recuperados

- Falta de contexto crítico

- Sobrerrepresentación de fuentes desactualizadas

- Exclusión silenciosa de datos autorizados

A medida que los sistemas de IA se vuelven más autónomos, los equipos deben evaluar el retrieval como un subsistema independiente. Esto incluye medir el recall bajo restricciones de políticas, monitorear la deriva de frescura y detectar sesgos introducidos por las rutas de retrieval.

En entornos de producción, la evaluación tiende a fallar una vez que el retrieval se vuelve autónomo en lugar de activado por humanos. Los equipos continúan calificando la calidad de las respuestas en prompts muestreados, pero carecen de visibilidad sobre qué fue recuperado, qué faltó o si el contexto obsoleto o no autorizado influyó en las decisiones. A medida que las rutas de retrieval evolucionan dinámicamente en producción, se acumula deriva silenciosa, y cuando los problemas surgen, las fallas a menudo se atribuyen erróneamente al comportamiento del modelo en lugar del sistema de retrieval en sí.

Arquitectura de referencia: Retrieval como infraestructura

Un sistema de retrieval diseñado para IA empresarial típicamente consta de cinco capas interdependientes:

- Capa de ingesta de fuentes: Maneja datos estructurados, no estructurados y en streaming con seguimiento de procedencia.

- Capa de embedding e indexación: Soporta versionado, aislamiento de dominio y propagación controlada de actualizaciones.

- Capa de políticas y gobernanza: Aplica controles de acceso, fronteras semánticas y auditabilidad en tiempo de retrieval.

- Capa de evaluación y monitoreo: Mide frescura, recall y adherencia a políticas de manera independiente de la salida del modelo.

- Capa de consumo: Sirve a humanos, aplicaciones y agentes autónomos con restricciones contextuales.

Esta arquitectura trata el retrieval como infraestructura compartida en lugar de lógica específica de aplicación, permitiendo un comportamiento consistente a través de casos de uso.

Casos de uso empresariales en 2025-2026

El mercado global de RAG pasó de $1.92 mil millones a una proyección de $10.20 mil millones para 2030, con una tasa de crecimiento anual del 39.66%. Las aplicaciones principales incluyen:

Automatización jurídica y cumplimiento: Los equipos legales utilizan RAG para revisar miles de páginas de contratos, mientras que los oficiales de cumplimiento buscan reglas específicas como GDPR. En finanzas, las instituciones emplean RAG para análisis de mercados, supervisión regulatoria e investigación de inversiones.

Atención al cliente: RAG potencia búsquedas avanzadas, integra datos de inventario en tiempo real y ofrece recomendaciones dinámicas. En retail, responde consultas de disponibilidad consultando bases de datos actualizadas.

Gestión de recursos humanos: RAG actúa como asistente virtual proporcionando respuestas precisas de manuales y guías técnicas, acelerando el onboarding con guías paso a paso basadas en casos reales.

Propuestas comerciales: Los agentes RAG cargan automáticamente RFPs, extraen requerimientos clave, generan propuestas usando secciones de casos similares customizadas y modelan opciones de pricing basadas en márgenes objetivo.

Por qué el retrieval determina la fiabilidad de la IA

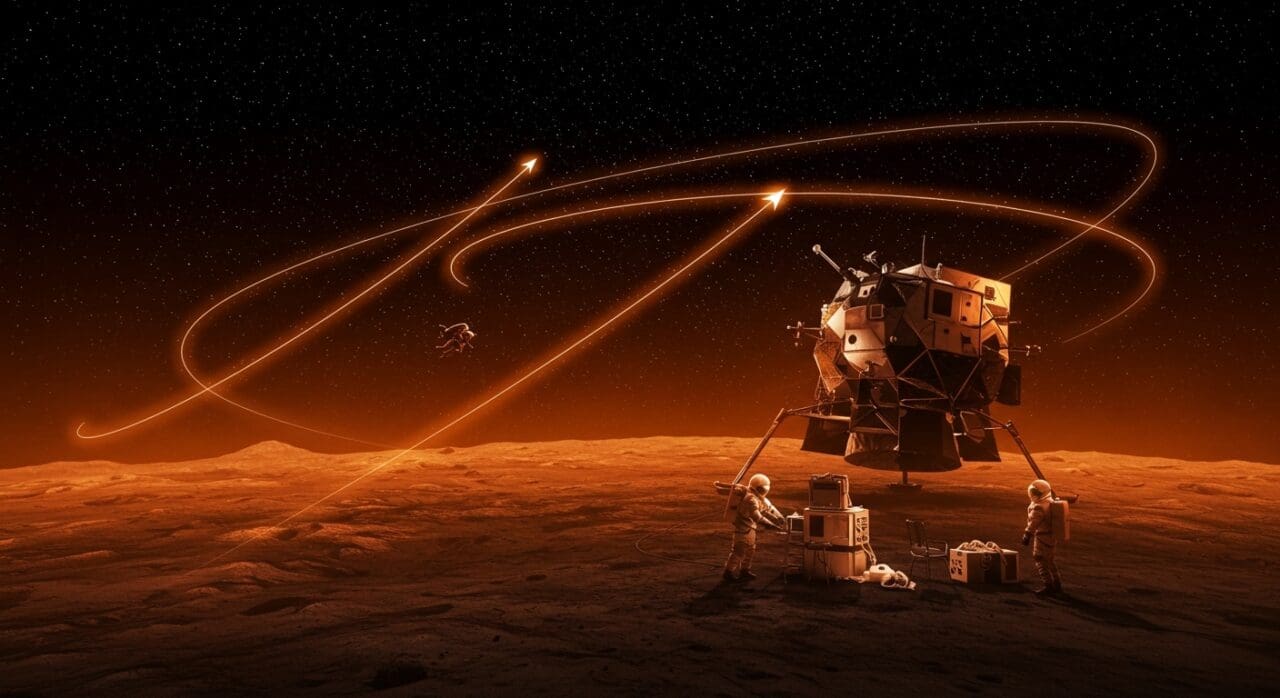

A medida que las empresas avanzan hacia sistemas agénticos y flujos de trabajo de IA de larga duración, el retrieval se convierte en el sustrato sobre el cual depende el razonamiento. Los modelos solo pueden ser tan confiables como el contexto que reciben.

Las organizaciones que continúan tratando el retrieval como una preocupación secundaria enfrentarán:

- Comportamiento del modelo inexplicable

- Brechas de cumplimiento

- Rendimiento inconsistente del sistema

- Erosión de la confianza de los stakeholders

Aquellas que eleven el retrieval a una disciplina de infraestructura —gobernada, evaluada e ingenierizada para el cambio— obtendrán una base que escala con autonomía y gestión de riesgo.

Conclusión

El retrieval ya no es una característica de soporte de los sistemas de IA empresariales. Es infraestructura.

La frescura, la gobernanza y la evaluación no son optimizaciones opcionales; son prerrequisitos para desplegar sistemas de IA que operen de manera confiable en entornos reales. A medida que las organizaciones avanzan más allá de despliegues experimentales de RAG hacia sistemas autónomos y de soporte a decisiones, el tratamiento arquitectónico del retrieval determinará cada vez más el éxito o el fracaso.

Las empresas que reconozcan este cambio temprano estarán mejor posicionadas para escalar la IA de manera responsable, resistir el escrutinio regulatorio y mantener la confianza a medida que los sistemas se vuelven más capaces y más consecuentes.

¿Implementando RAG en tu startup? Conecta con founders que están construyendo infraestructura de IA escalable y descubre cómo están resolviendo los desafíos de retrieval, gobernanza y evaluación en producción.

Fuentes

- https://venturebeat.com/orchestration/enterprises-are-measuring-the-wrong-part-of-rag (fuente original)

- https://www.aplyca.com/blog/retrieval-augmented-generation-RAG-guia-empresarial-completa-y-mejores-practicas

- https://blog.formaciongerencial.com/casos-de-uso-de-ia-generativa-la-guia-completa-para-transformar-tu-negocio

- https://www.datacamp.com/es/blog/rag-vs-cag

- https://agentesautonomosia.com/agentes-ia-autonomos-2026